وحدة معالجة الرسومات GPU مراحل تطورها وصراع Nvidia وAMD

محتوى المقال

في هذه المقالة سنغطي تاريخ وحدة معالجة الرسومات GPU وتطورها بمرور الزمن من الانطلاق الأول إلى ATI ثم AMD وصولاً الى Nvidia وهيمنتها في وقتنا الحاضر على هذا المجال، وأيضا سنستعرض سجل أسعار AMD وNvidia .

بداية وحدة معالجة الرسومات المبكرة 1985-1949

أن GPU هي أول إلكترونيات في الوقت الحاضر قادرة على معالجة الكود لعرض الرسومات وأيضا هي الأب لجميع أجهزة الكمبيوتر الحديثة مثل جهاز محاكاة الطيران التابع لMIT المطور للبحرية الأمريكية، وهو أول كمبيوتر يتم معالجته بالتوازي على عكس الحوسبة الخطية البسيطة، وان الصياغة الفنية له bit-parallel موازية للبت بدلاً منsingle-bit البت المفرد، وعلى الرغم من انه لم يتم الانتهاء منه حتى عام 1951 إلا انه بحلول عام 1949 تمكن من تشغيل أول لعبة كمبيوتر تفاعلية.

وان النظام الثاني GPU تم تطويره بطريقة رقمية من قبل Curtis-Wrightفي عام 1954، وان الرسوم ثلاثية الأبعاد وتقنيات وحدة معالجة الرسومات الأخرى كانت متاحة في وقت مبكر في ستينيات القرن الماضي لكنها كانت سرية للغاية وحصرية فقط للحكومة والمختبرات العلمية في الجامعات وشركات الطيران وشركات السيارات .

في عام 1980 قام جيمس كلارك James Clark في ستانفورد باستخدام مصطلح (VLSI geometry processor for graphics)، أي معالجة هندسة الرسومات والذي يعادل تقريباً وحدة معالجة الرسومات.

GPU وعصر الألعاب من السبعينيات الى الثمانينيات

إن أول تطبيقات المستهلك وحدة معالجة الرسومات كانت في ألعاب الأركيد القديمة التي كانت قدرتها محدودة للغاية ولقد حملوا بشكل أساسي معلومات المعالج الى الشاشة، وفي تلك السنوات تحركت بمرور الوقت تقنية GPU بشكل بطيء جداً وكانت الرسومات بدائية للغاية ، ومثال على تلك الألعاب.

وفي عام 1976 قامت شركة RCA بإنتاج شريحة الفيديو الخاصة بها pixie، لكنها كانت أحادية الألوان وصغيرة 68*128.

في عام 1979، طورت شركة Xerox أول واجهة مستخدم رسومية في مركز بالو ألتو للأبحاث كمشروع تعاوني كبير، كان يحتوي على نوافذ وأيقونات وقوائم منسدلة والعديد من الميزات المألوفة الأخرى.

بعد ثلاث سنوات، قامت شركة Namco Galaxian بتطوير رقائق الرسومات لدعم الألوان أي النقوش المتحركة ذات الألوان المتعددة والخرائط في الخلفية، كان ذلك قبل عام 1980 مباشرة.

بالإضافة الى أن شركة IBM صنعت ما يمكن تسميته ببطاقة الفيديو الأولى باستخدام محولIBM Monochrome Display Adapter، ثم أصدرت IBM بطاقة دعم 8 ألوان في عام 1983، ISBX 270، والتي كانت مبتكرة في ذلك الوقت، إذا كانت باهظة الثمن إلى حد ما تصل إلى 1000دولار، أي ما يعادل في وقتنا الحاضر 2633 دولار.

قامت Sony بعد ذلك بصياغة وحدة معالجة الرسومات GPU في إشارة إلى PlayStation الخاصة بهم في عام 1984(على الرغم من تصميمها بواسطة Toshiba).

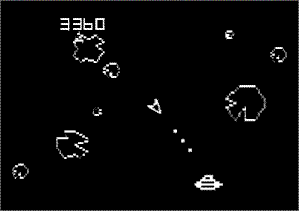

ثم الذي أصبح عملاقًا في تاريخ وحدة معالجة الرسومات، هي شركة ATI التي تأسست في عام 1985 من قبل الأخوين Lau و Kwok Yuen Ho، مهاجري هونغ كونغ الذين يعيشون في كندا. تم شراء ATI في النهاية بواسطة AMD. الذي سنستعرضه لاحقاً بالتفصيل.

اقرأ: ما هو كرت الشاشة وما هي مكوناته

في عام 1986، أطلقوا أول سلسلة من وحدة معالجة الرسومات الرائعة الخاصة بهم، كانت هذه البطاقات مهيمنة في ذلك الوقت لأنها دعمت العديد من الشاشات ومعايير الرسومات في بطاقة واحدة ، بينما لم يدعمها البعض الآخر.

في عام 1987، تم إصدار موصل مصفوفة رسومات الفيديو، أو VGA. الذي أصبح المعيار السائد في الرسومات.

في عام 1989، لمعالجة نقص التوحيد القياسي في صناعة رسومات الكمبيوتر، تم تأسيس جمعية معايير الإلكترونيات المرئية من قبل ATI وسبع شركات أخرى، وأصبحت اليوم أكثر من 300 شركة أعضاء.

تاريخ GPU الحديث وحروب AMD و Nvidia (من التسعينيات حتى اليوم)

من الغريب أن نعلم أن كل من Nvidia و ATI بدأتا بداية صعبة في التسعينيات، تم إعاقة NV1 من Nvidia من خلال إصدار DirectX 1.0 بعد وقت قصير من إصداره، والذي لم يكن متوافقًا معه.

وقد عانى Rage 1 من ATI أيضًا بسبب توافق DirectX 1.0، على الرغم من أن أداءه كان ثنائي الأبعاد وجيد.

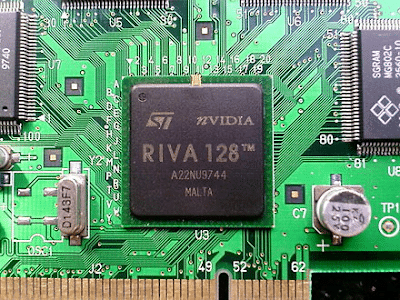

في حين أن ATI قد شهدت بالفعل بعض النجاح منذ سنوات سابقة، برزت شركة Nvidia لأول مرة مع إطلاق وحدة معالجة الرسومات Riva في عام 1997، والتي باعت مليون قطعة في غضون أربعة أشهر فقط. جاءت شعبيتها في جزء كبير منها بسبب حقيقة أنها كانت عادلة ولقد دعمت تسريع ثنائي الأبعاد وثلاثي الأبعاد وتسريع الفيديو، ولم تكن وظائفها ثانوية أيضًا، كما هو الحال مع العديد من صانعي وحدة معالجة الرسومات.

Nvidia Riva 128

بدأ عهدهم بالفعل مع Riva TNT 2، كانت واجهة برمجة تطبيقات 3dfx ,Glide، تخسر أمام DirectX و OpenGL، والتي بدأت في الانهيار وعززها GeForce.

في عام 1999، استخدموا مصطلح GPU على نطاق واسع مع “أول GPU في العالم”، GeForce 256، لم تكن بالفعل أول GPU فمنذ عصر كلارك، واصل الأكاديميون استخدام اختصار GPU للدلالة على المعالجة الهندسية.

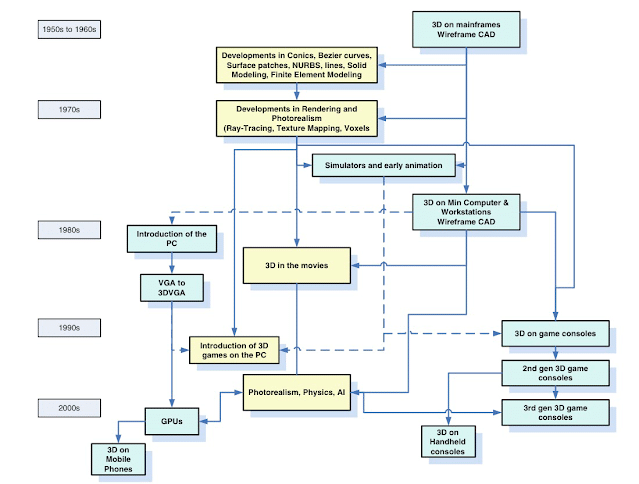

أدناه رسم توضيحي “خريطة ذهنية” جميل للكاتب (جون بيدي) في كتابة (تاريخ السحر البصري لأجهزة الكمبيوتر) يوضح به المراحل التي مر بها GPU من خمسينيات القرن الماضي وحتى عام 2000 .

المخطط الزمني Nvidia/AMD وبداية عصرهم

وجدت Nvidia نفسها في وضع فريد للغاية في مطلع الألفية، في حين أن شركات مثل 3D Labs صنعت وحدات شرائح متعددة مصممة لسوق محطات العمل مثل Glint.

واصلت Nvidia الاستفادة من سوق ألعاب الفيديو سريع النمو، والذي اكتسب عددًا أكبر بكثير من المستخدمين. نتيجة لذلك، وجدت Nvidia نفسها ليس فقط مع سوق الألعاب، ولكن أيضًا مهيمنة على سوق مراكز العمل والمؤسسات بالإضافة إلى سوق الألعاب الذي دفع أرباحها الى الارتفاع وزيادة ضخمة بميزانية البحث والتطوير. بعض إصدارات الألعاب البارزة التي نشأت منها كانت PlayStation 3 وWorld of Warcraft وXbox.

أصدرت Nvidia جيلها الثاني من GeForce في عام 2000، والذي حقق أداءً جيدًا على الرغم من بطئ 166 ميجاهرتز DDR، حيث كانت لا تزال أسرع بطاقة حتى أصدرت ATI بطاقة Radeon 7200 )ملاحظة جانبية أصدرت Nvidia أول منتج رسومات مدمج لها في عام 2001 مع nForce).

يتميز Radeon 7200 بسرعة ذاكرة أفضل، وتقنية تحسين عرض النطاق الترددي الجديدة تسمى HyperZ، وتقنية رسم الخرائط الأكثر اكتمالا حتى الآن.

أجابت Nvidia من خلال GeForce 2 GTS التي قدمت ما يقرب من نصف النسبة المئوية للتحسين، وفازت بمكانة ألعاب OpenGL وبالتأكيد 16 بت في Direct3D، لكن تم إعاقة هيمنتها بسبب ضعف عرض النطاق الترددي للذاكرة.

في هذا الوقت تقريبًا، بدأت Nvidia في الاستفادة من قطاع محطة العمل باستخدام كوادرو، والذي كان أساسًا مجرد بنية GeForce 2 مع تركيز أكبر على الدقة والموثوقية (من خلال استخدام ذاكرة ECC)، من خلال إعادة تعبئة GeForce بمزيد من الأجراس والصفارات وميزات التجزئة فقط حسب الحاجة بين البطاقات، يمكن أن تفرض Nvidia علاوة على Quadro تظل قادرة على المنافسة مع أسعار بطاقات الألعاب، مع منع محطات العمل من استخدام GeForce الأرخص.

اقرأ: التكنولوجيا والذكاء الاصطناعي في 2021

على الرغم من أن Radeon عالج مشكلات عرض النطاق الترددي للذاكرة مع HyperZ من بين ميزات أخرى، إلا أنه لا يزال لا يُقارن بشكل إيجابي للغاية مع Voodoo 5 5500 أو GeForce 2 GTS، على الرغم من أنه حقق أداءً جيدًا بدرجة كافية في لون 32 بت ولا يزال يُباع بشكل معقول.

ثم أجابت ATI بـ Radeon 9700 Pro. لقد دعمت ألوان64 و 128 بت، DirectX 9 ، AGP 8X ، ولها مواصفات رائعة لشريحة0.15 ميكرون.

لم يكن لدى Nvidia منافس حقيقي حتى عام 2004، مع GeForce 6800. في عام 2006، دخلنا في العصر الحديث لوحدة معالجة الرسومات مع الجيل الثامن من بطاقات GeForce 8800، وقد حظيت بشعبية كبيرة، وبدأنا في رؤية العرض والتخطيط والتظليل، الإضاءة، والمعالجة اللاحقة، وما إلى ذلك ، التي هي في نفس مجال الجودة مثل بطاقات العقد الماضي. على سبيل المثال، يمكن أن تلعب لعبة Bethesda’s Skyrim ، والتي لا تزال لعبة شائعة اليوم.

في نفس الوقت تقريبًا، أصبحت Nvidia صانع شرائح الرسومات المستقل الوحيد الذي لا يزال يعمل بعد استحواذ AMD على ATI.

لقد طوروا بنية تسلا التي دعمت التظليل الموحد، وتخلصوا من الهياكل الدقيقة لخط الأنابيب الثابتة، تم استخدامه على طول الطريق حتى يموت 40 نانومتر. كان هذا مهمًا للغاية للانتقال إلى وحدة معالجة الرسومات للأغراض العامة، بدلاً من وجود مجموعة من الوحدات المنفصلة، مثل تظليل الرأس / البيكسل، كان لديك معالجات تدفق أكثر عالمية. كانت أكثر كفاءة في مجموعة واسعة من حالات الاستخدام، ولأنها كانت بسيطة، يمكن زيادة سرعات الساعة.

في عام 2007، أصدرت Nvidia Cuda، وشاهدت سمحت لمطوري البرامج / المهندسين باستخدام وحدة المعالجة المتوازية لوحدات معالجة المهام الخاصة بهم أكثر عمومية.

اليوم يعد اسم GPU من مخلفات الماضي الخاطئة، حيث تفرعت تقنية GPU بشكل كبير عن الألعاب على مدار العقد الماضي.

يستعمل الإن نظام الرقاقات، أو SoCs كما يطلق عليهم عادة، لديهم جميع الدوائر والوظائف التي قد تتوقعها من مجموعة من المكونات المنفصلة ، ولكن كنظام واحد موحد، على وجه التحديد، لديك معالج يتمتع بقدر كبير من المعالجة المتوازية، جنبًا إلى جنب مع محرك تسريع الشبكة العصبية، ومعالجات الإشارات الرقمية لترجمة مدخلات الصورة التناظرية والصوت ، والمرشح، وما إلى ذلك.

تُستخدم وحدة معالجة الرسومات اليوم لتسريع التطبيقات الهندسية، ونمذجة الفيزياء، والصواريخ، والتحليل المالي والتجارة، والتصوير الطبي، والبحوث السريرية، والتعلم الآلي، على سبيل المثال التي لا حصر لها.

على سبيل المثال، ربما يكون أكثر التطبيقات التي تواجه الواجهة الأمامية، يتم استخدام GPU على نطاق واسع كأداة استنتاج بالذكاء الاصطناعي في الهواتف والمركبات.

Nvidia Drive ، العقول التي عملت على تنمية قدرات المركبات المستقلة على الرغم من أنها ليست ذكاءً اصطناعيًا حقًا ، إلا أنه لا يزال يشار إلى وحدة معالجة الرسومات على أنها “محركات استنتاج الذكاء الاصطناعي” ، وهي في الحقيقة مجرد طريقة رائعة للقول إنها تستمد “استنتاجات” أو رؤى من البيانات الموجودة، على سبيل المثال، إذا كان لديك صور Google أو تطبيق صورة سحابي آخر، فقد تلاحظ أنه يتعرف على صور أخرى لنفس الشخص بداخله ، ثم قم بتجميعها معًا. يتم تحقيق ذلك من خلال وحدة معالجة الرسومات إلى حد كبير من خلال “التدريب” حيث قد تسألك Google “هل هذا هو نفس الشخص؟”

اقرأ: وسيلة النقل المستقبلية من ايلون ماسك

السبب الذي يجعل وحدة معالجة الرسومات تفسح المجال لهذه المهمة هو أنه لتدريب مثيل التعلم الآلي من هذا القبيل، فإنه يتطلب قدرًا هائلاً من قدرة المعالجة الكمية الخام، حيث يجب مسح تيرابايت من الصور واحدة تلو الأخرى. إن قابلية التوسع الهائلة لمعالجات التدفق تفسح المجال لهذه الأنواع من المهام بشكل جيد للغاية.

مثال آخر على تقنية GPU الحديثة هو المسح ثلاثي الأبعاد للأجسام، كما هو الحال مع التصوير بالرنين المغناطيسي، أو التصوير بالرنين المغناطيسي، الذي ابتكرته Nvidia أيضًا إلى حد كبير.

إذا كنت تتابع الأخبار عن كثب، فربما تكون قد شاهدت ظاهرة “الطي في المنزل”، حيث سمحت الحواسيب الفائقة والحوسبة الجماعية للباحثين بفهم ميكانيكا البروتين في Sars-Cov-2 أو Covid-19 بشكل أفضل. كانت Exit Technologies في الواقع واحدة من أهم المساهمين في قوة معالجة هذا المشروع، وقد تم إنجازها إلى حد كبير من خلال استخدام العديد من وحدة معالجة الرسومات المستخدمة بشكل متوازي، أحد الأنظمة التي استخدمناها للطي في المنزل.

حيث كان مشروع من هذا القبيل قد يستغرق شهورًا في السنوات السابقة، فقد نمت تقنية GPU بمرور الوقت بما يكفي بحيث يمكننا استخلاص رؤى مثل آليات الالتحام الجزيئي لبروتين ارتفاع Covid-19 في أيام.

بمعنى أكثر شمولية، تعمل وحدة معالجة الرسومات للأغراض العامة على تسريع العمليات بشكل كبير لتقليل الوقت الذي يستغرقه المهندسون والباحثون ومطورو البرامج وما إلى ذلك، لحل المشكلات وإنشاء تصميمات جديدة وتحليل مجموعات ضخمة من البيانات، ومن هنا جاء مصطلح تسريع التطبيق.

ليس هذا فقط، ولكن الإجابات التي نحصل عليها أكثر دقة وموثوقية؛ عندما تحتاج إلى تقليل البيانات للعثور على إجابة بسرعة، فإنك تضحي بقدر كبير من الدقة والدقة.

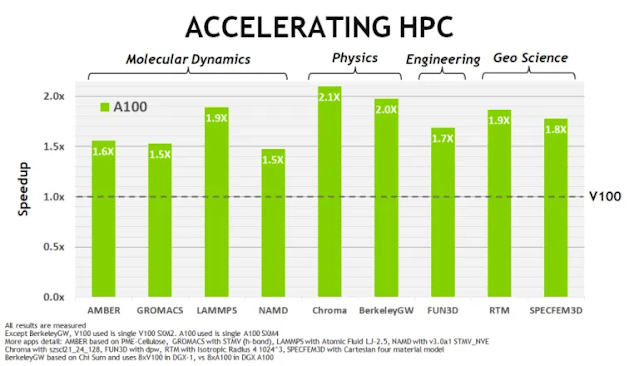

هذا العام، حققت Nvidia قفزة متقدمة على كل شركة أخرى في العالم من حيث قوة المعالجة الكمية الخام من خلال معالج A100 وأنظمة DGX من الجيل الثاني.

اقرأ: كرت الشاشة RTX 3060 Ti من نفيديا

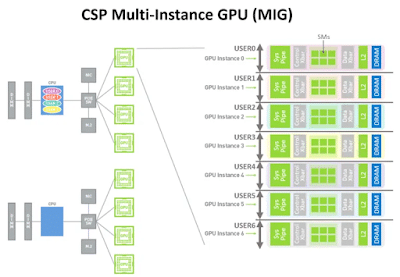

يتسع لـ 54 مليار ترانزستور في بضع مئات من المليمترات. يمكن تقسيم كل قوة الحوسبة الخام إلى 7 من وحدة معالجة الرسومات منفصلة تعمل بشكل مستقل، أو وحدة معالجة رسومات متعددة المثيلات (MIG).

ضاعف الجيل الثالث من NVlink سرعة الاتصال بين المعالجات، وقاموا ببناء تناثر في الجهاز نفسه، هذا جنبًا إلى جنب مع نوى الموتر من الجيل الثالث، يعني أن خادم وحدة معالجة الرسومات A100 واحد يوفر 5 تقلبات من الخرج. لقد قدمت

استنتاجًا أفضل 7 مرات وأداء تدريبي أفضل 6 مرات. في الواقع، قدمت A100 أكبر قفزة في جيل واحد من أي إصدار من Nvidia.

هندسة Nvidia Ampere

في الواقع، بضربة واحدة سريعة، مكّنت Nvidia نظامًا واحدًا من فعل ما كان ممكنًا فقط مع مركز بيانات ضخم من قبل، يتنافس DGX SuperPOD الفردي المصنوع من خوادم A100 مع أسرع أجهزة الكمبيوتر العملاقة في العالم.

حيث استغرق الأمر في الماضي شهورًا إلى سنوات لإكمال مشروع كمبيوتر عملاق ضخم، لم يستغرق الأمر سوى أسابيع Nvidiaللحصول على لقب أسرع كمبيوتر عملاق في العالم.

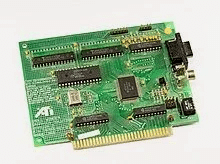

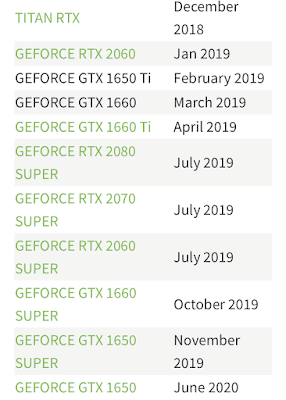

جدول لتاريخ إصدارات Nvidia

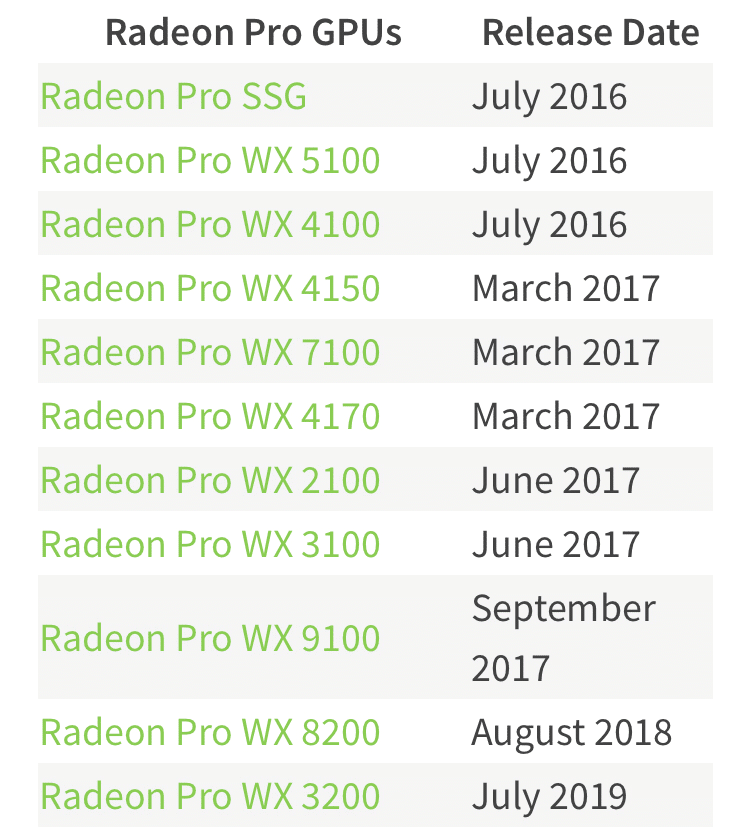

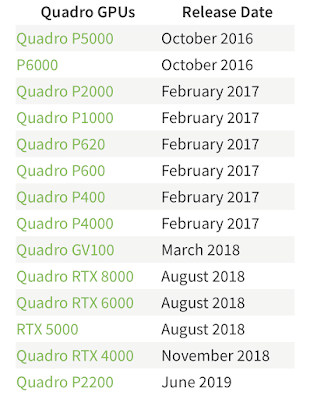

جدول لتاريخ إصدارات AMD